DeepSeek爆火,本地轻松部署实现自由使用

最近,开源 AI 大模型 DeepSeek 爆火,成功出圈。亲自试用后,它给我的办公效率带来了显著提升。但春节过后,不知是受外网 DDoS 攻击影响,还是用户数量激增,DeepSeek 官方服务频繁提示繁忙。恰好我有一台 NAS,为了使用方便,决定将其部署到自己的服务器上。

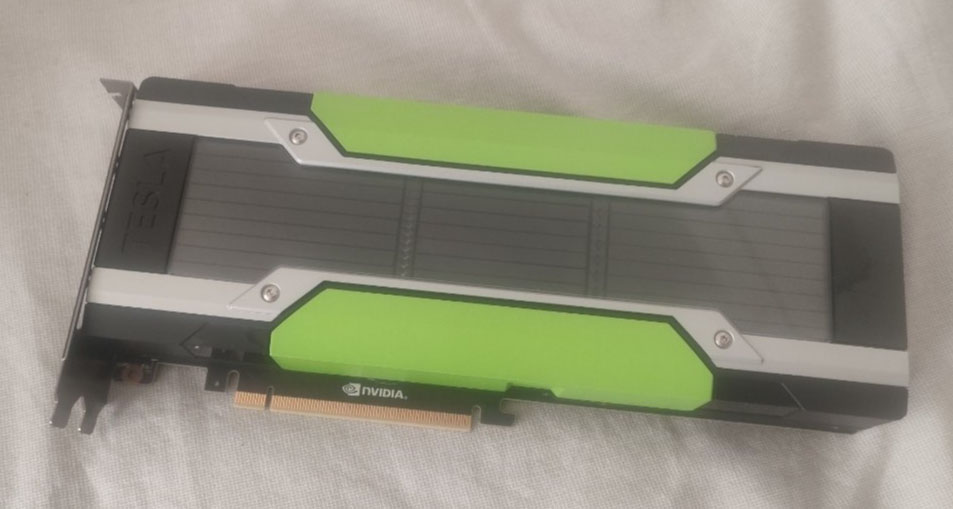

我的 NAS 是十年前自行组装的,最近刚把操作系统升级到 Windows 11,硬件配置为 i3 - 4160 CPU、B85 主板、8GB DDR3 内存,另外还配备了几块用于存储数据的硬盘。要部署 DeepSeek 模型,需要添置一块性能尚可的显卡。正好我手里有去年购入的 Tesla M40,价格亲民且性能能够满足需求,就是它了!不过这张卡本身没有散热风扇,需要手动改装。我在显卡尾部安装了一个 USB 供电的涡轮风扇,操作难度不大。完成散热改装后,将显卡安装到主板上,开机并安装好 CUDA 驱动,硬件部分就准备就绪了。

硬件搞定后,就轮到软件了。在 Windows 系统中部署 DeepSeek,有一个简单快捷的方法:

下载并安装Ollama:前往https://github.xzc888.top/ollama/ollama/releases/latest/download/OllamaSetup.exe,把这个链接复制到多线程下载工具中能加速下载,下载完成后一路点击下一步即可完成安装。

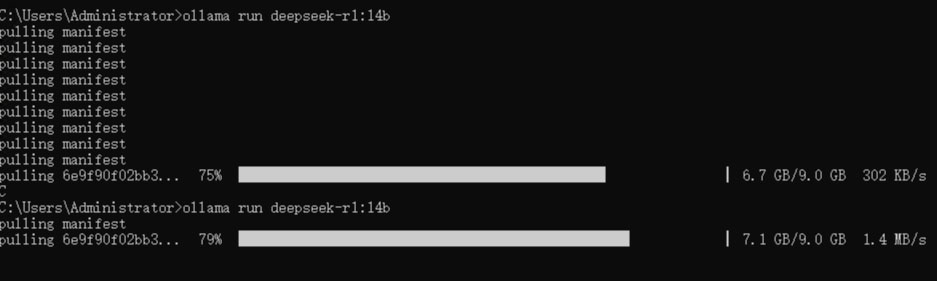

选择模型:进入https://ollama.com/library/deepseek-r1:14b,根据自己显存大小进行选择,选好后点击后面的复制按钮,然后在本地电脑打开命令行,粘贴并运行。

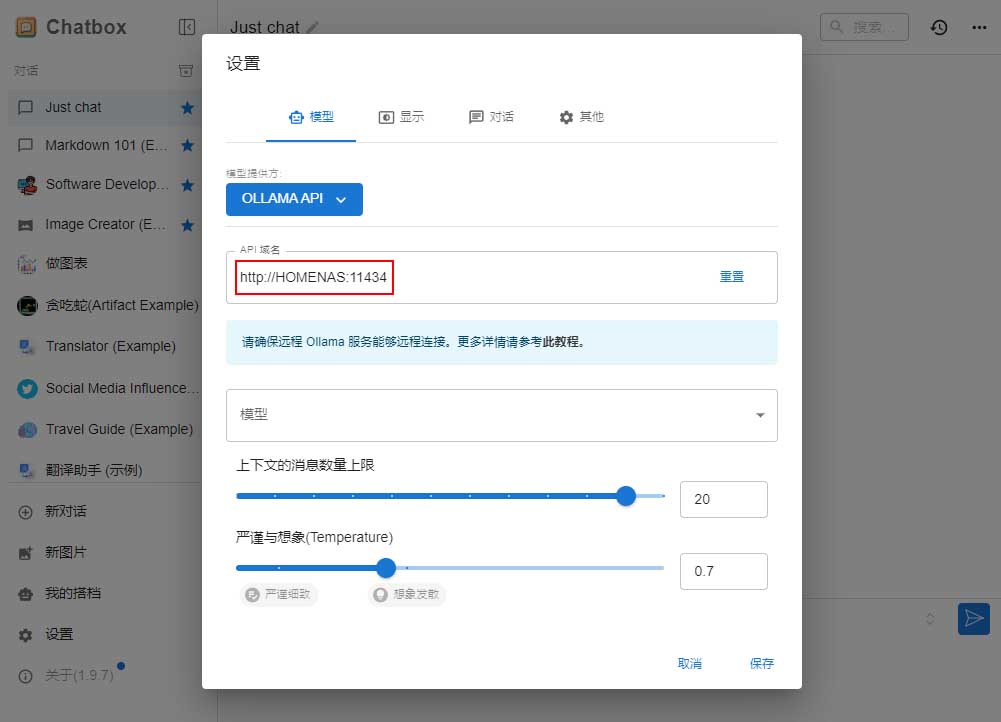

完成上述两步,本地部署就大功告成了。说到使用,Chatbox 应该是最简单且最接近官方体验的方式。Chatbox 支持网页版,只要记住 NAS 的 IP 地址或者域名,无论身处何地,只要有网络,就能在任意电脑上接入自己部署的 DeepSeek 模型。

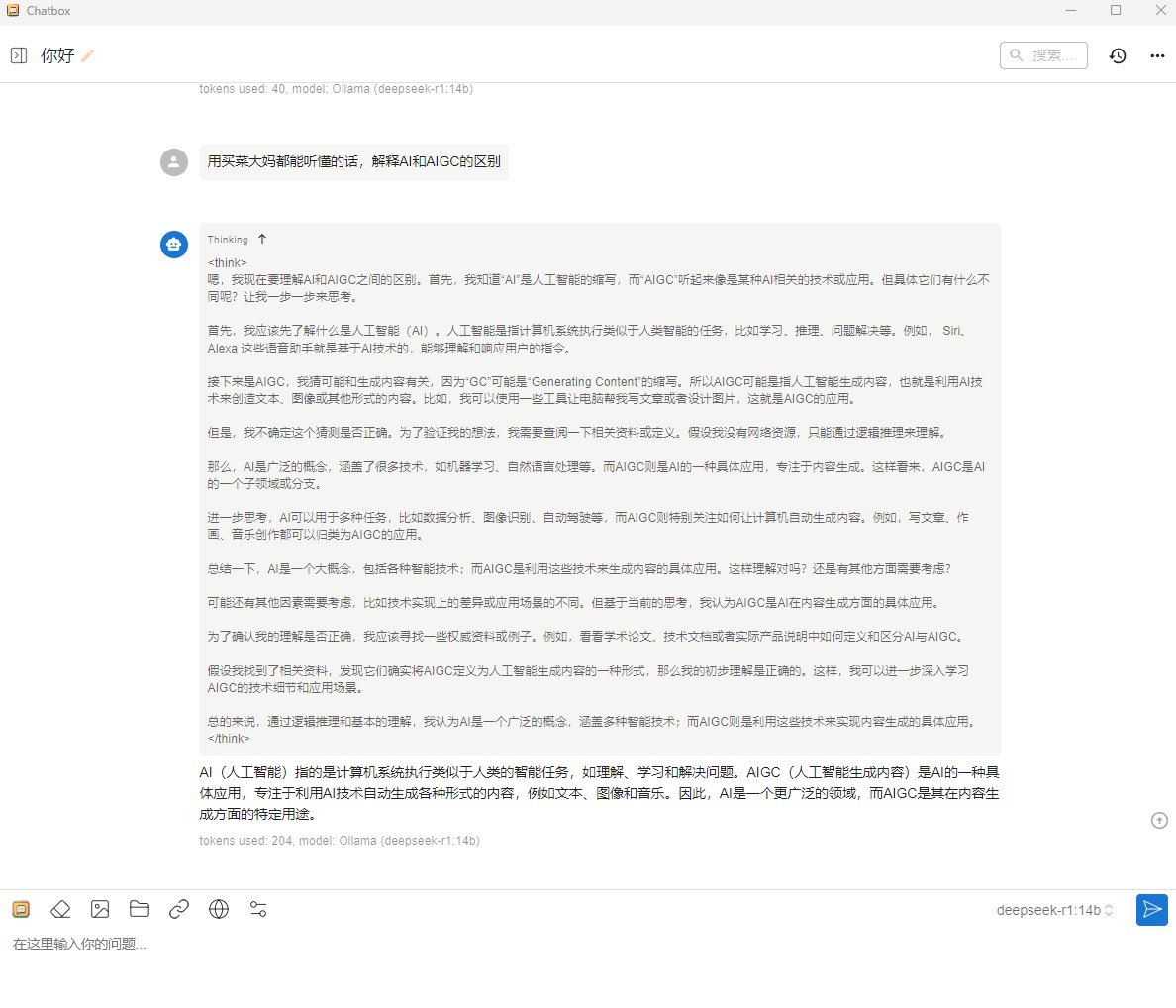

来试试聊天功能:

完美!DeepSeek 部署成功,这下再遇到官方服务繁忙的情况,也能在本地畅快使用了。

我就是用现成的了,懒得折腾。

我现在也用现成的了哈哈

你这个卡牛逼啊,比我笔记本4070还牛

这个主要对显存要求高,算力肯定比不了4070的

不是说自己部署需要很好的硬件吗,你这个硬件感觉也很一般啊

不是的,个人使用对硬件要求不是很高,家用电脑基本都能部署。个人部署的是蒸馏模型,32b以下的只要显存+内存超过20GB就可以了

反代共享下不?

不是我的,只是借用

牛人,我最多只能在VPS上照猫画虎

谦虚了